88API 多模型一站式接入教程(国内工具,适配国外模型)

1. 工具概述

88API是国内主流的AI模型聚合平台,支持一站式调用GPT-5.2、Claude Opus 4.5、Gemini 3等国外顶尖模型,解决国内开发者直接接入国外模型时的网络限制、账号管理、支付繁琐等问题。其兼容OpenAI接口格式,国内直连低延迟,支持高并发,适合企业级应用开发和个人开发者快速集成AI能力。

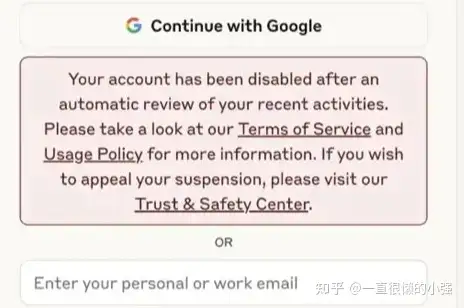

2. 前期准备

1. 平台注册与API Key获取:访问88API官网( base_url="

)

def chat_with_gpt5():

try:

# 调用GPT-5.2 Instant模型

response = client.chat.completions.create(

model=" gpt-5.2-instant",="" #="" 模型名称,与官方一致

{"role": "system", "content": "你是一个资深AI技术专家,回答简洁专业"},

{"role": "user", "content": "请对比GPT-5.2与GPT-4的核心差异"}

],

temperature=0.7, # 0-1,数值越高创意性越强

max_tokens=1024 # 最大输出长度

)

# 提取并打印回复

print("GPT-5.2 回复:")

print(response.choices[0].message.content)

except Exception as e:

print(f"调用失败:{str(e)}")

if __name__ == "__main__":

chat_with_gpt5()

3.2 运行与验证

1. 创建.env文件,写入“88API_KEY=你的密钥”,与demo_gpt5.py放在同一目录。

2. 运行代码:在终端执行“python demo_gpt5.py”,等待几秒后即可获取GPT-5.2的回复,无需科学上网,国内网络环境可直接调用。

3. 结果排查:若出现调用失败,检查API Key是否正确、额度是否充足、网络是否通畅,可在控制台查看调用日志定位问题。

4. 进阶实战:多模型对比调用与企业级适配

4.1 多模型切换与基础适配

1. 多模型切换:仅需修改代码中的model参数即可切换模型,示例:调用Claude Opus 4.5设置model="claude-opus-4.5",调用Gemini 3设置model="gemini-3-pro",无需修改其他代码逻辑,兼容性极强。

2. 批量调用与并发控制:在企业级场景中,可通过多线程实现批量调用,结合88API的并发控制功能,在控制台设置每秒调用次数上限,避免触发限流。

3. 错误处理优化:完善代码中的异常捕获逻辑,针对不同错误类型(如额度不足、网络超时、模型暂不可用)返回对应提示,提升应用稳定性。

4.2 进阶实战:多模型智能路由(企业级场景)

场景需求:开发一个AI问答服务,根据用户问题类型自动选择最优模型(知识类问题用GPT-5.2,代码类问题用Claude Opus 4.5,创意类问题用Gemini 3 Pro),同时实现失败重试、请求缓存功能,提升服务稳定性与响应速度。

1. 代码实现:创建multi_model_router.py文件,核心代码如下:

from openai import OpenAI

import os

from dotenv import load_dotenv

from functools import lru_cache

import threading

import time

load_dotenv()

client = OpenAI(api_key=os.getenv("88API_KEY"), base_url=")

# 问题类型判断(简化版,实际可结合NLP优化)

def classify_question(question: str) -> str:

code_keywords = [" 代码",="" "编程",="" "重构",="" "报错",="" "脚本"]

if any(keyword in question for keyword in code_keywords):

return "code"

elif any(keyword in question for keyword in creative_keywords):

return "creative"

else:

return "knowledge"

# 缓存装饰器,缓存重复请求(过期时间300秒)

@lru_cache(maxsize=1000)

def get_cached_response(question: str, model: str) -> str:

response = client.chat.completions.create(

model=model,

messages=[{"role": "user", "content": question}],

temperature=0.6,

max_tokens=1024

)

return response.choices[0].message.content

# 失败重试装饰器

def retry_decorator(max_retries=3, delay=2):

def decorator(func):

def wrapper(*args, **kwargs):

retries = 0

while retries < max_retries:

try:

return func(*args, **kwargs)

except Exception as e:

retries += 1

print(f"调用失败,第{retries}次重试,错误:{str(e)}")

time.sleep(delay)

raise Exception(f"超过最大重试次数({max_retries}次),调用失败")

return wrapper

return decorator

# 多模型路由核心函数

@retry_decorator(max_retries=3, delay=2)

def ai_router(question: str) -> str:

question_type = classify_question(question)

model_map = {

"knowledge": "gpt-5.2-instant",

"code": "claude-opus-4.5",

"creative": "gemini-3-pro"

}

model = model_map[question_type]

# 优先从缓存获取结果

try:

return get_cached_response(question, model)

except Exception:

# 缓存获取失败,重新调用并缓存

response = client.chat.completions.create(

model=model,

messages=[{"role": "user", "content": question}],

temperature=0.6,

max_tokens=1024

)

result = response.choices[0].message.content

get_cached_response.cache_clear() # 清除缓存,重新缓存新结果

return result

# 多线程批量处理示例

def batch_process_questions(questions: list):

threads = []

for q in questions:

t = threading.Thread(target=lambda x: print(f"问题:{x}\n回复:{ai_router(x)}\n---"), args=(q,))

threads.append(t)

t.start()

for t in threads:

t.join()

if __name__ == "__main__":

test_questions = [

"请解释什么是区块链共识机制?", # 知识类

"用Java写一个单例模式的双重校验锁实现", # 代码类

"为一款奶茶写3条小红书创意文案", # 创意类

]

batch_process_questions(test_questions)

2. 功能验证:运行代码后,程序将自动分类问题类型,调用对应模型,重复问题将从缓存获取结果,调用失败时自动重试3次。通过88API控制台查看各模型调用日志,确认路由逻辑正确,并发调用无限流问题。

3. 企业级优化:实际部署时,可将缓存替换为Redis(支持分布式缓存),添加请求队列控制并发量,结合监控工具实时监控模型调用状态、响应时间及错误率,确保服务稳定运行。

5. 优势与注意事项

优势:一个API Key调用多模型,简化账号管理;国内直连低延迟,无需VPN;兼容OpenAI接口,原有项目可无缝迁移。注意事项:妥善保管API Key,避免泄露导致恶意调用;根据实际需求选择模型,控制调用额度,避免超额产生额外费用;企业级部署需做好并发控制与监控,确保服务可用性。